Ein Klassiker der Probleme, die mithilfe eines Business Intelligence Tools wunderbar gelöst werden können, ist die sogenannte Warenkorbanalyse. Besser bekannt als ‚Kunden kauften auch …‘. Dabei wird untersucht, welche Artikel zusammen geshoppt werden und somit auf dem gleichen Bon stehen. Den direktesten Einblick gewähren dabei einfache Zählungen der Art: Kunde kaufte Produkt X, dann wurde in wie viel Prozent der Fälle Produkt Y gekauft? Dieser schnell nachvollziehbare Teil einer Assoziationsanalyse ist oftmals ein guter Start, um Marketing- und Produktplatzierungsstrategien zu entwickeln.

„Eine derartige Analyse übersieht allerdings viele Zusammenhänge in den vorliegenden Daten“, merkt Managing Consultant Matthias Wiciok an. So wird beispielsweise nicht beachtet, wie sich die Kaufwahrscheinlichkeit ändert, wenn zusätzlich Produkt Z gekauft wird. „Potenzielle Einflussfaktoren wie die gesamte Warenkorbgröße und -diversität sowie die Kaufhistorie des Kunden oder der Wochentag und die Uhrzeit werden außerdem ausgeblendet, um nur ein paar nahe liegende Zusammenhänge aufzuzählen“, führt er weiter aus.

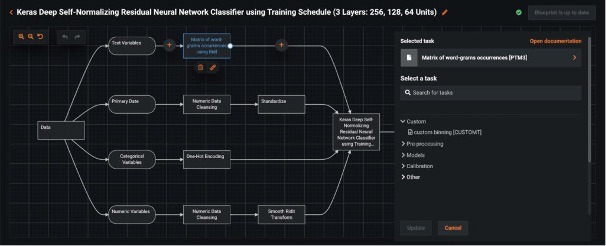

Um diese und weitere Treiber zu analysieren und sie für eine valide Kaufwahrscheinlichkeit zu benutzen, sollte Artificial Intelligence (AI) eingesetzt werden. Mit geeigneten Machine-Learning-Algorithmen kann man zum einen den Einfluss der einzelnen Dimensionen herausfinden. Zum anderen kann in Bruchteilen einer Sekunde ausgegeben werden, welche Produkte mit der höchsten Wahrscheinlichkeit ebenfalls in den Einkaufskorb wandern und damit zum Beispiel live seinen Online-Shop so bespielen, dass unter der Rubrik ‚Kunden kauften auch …‘ eben diese Produkte aufgeführt werden.

Dies stellt beispielhaft einen Use Case dar, bei welchem durch den Einsatz von AI eine bereits starke BI-Landschaft sinnvoll erweitert wird und den nächsten, logischen Schritt aufzeigt. Das Beispiel verdeutlicht zusätzlich, dass AI verschiedenste Unternehmen sogar bei alltäglichen Problemen unterstützen kann und an dieser Stelle bereits immense Verbesserungen mit sich bringt.