Doppelt hält (wesentlich) besser

Wesentlichkeit in der Nachhaltigkeitsberichterstattung

Eine der bedeutenden Neuerungen, die mit der CSRD einhergehen, ist die Einführung des Konzepts der „Double Materiality“, auf Deutsch „Doppelte Wesentlichkeit” oder „Doppelte Materialität“ genannt.

Analog zu finanziellen Rechenschaftspflichten sollten Nachhaltigkeitsberichte Informationen enthalten, die für den Adressatenkreis relevant und bewertbar sind. Dieses Gebot der aussagekräftigen Informationen wird als „Wesentlichkeit“ bezeichnet. Eine Wesentlichkeitsanalyse sollte immer auch die Sicht aller Stakeholder eines Unternehmens umfassen. Relevante Stakeholder können Aktionäre, Banken, Investoren, Lieferanten, Geschäftspartner, Kunden, Mitarbeitende, Arbeitnehmervertreter, Anwohner, etc. sein.

Doppelte Wesentlichkeit

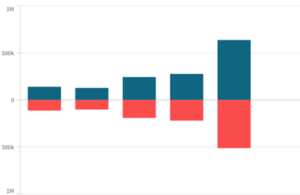

Das Prinzip der doppelten Wesentlichkeit zwingt Unternehmen dazu, die Nachhaltigkeitsaspekte ihrer Geschäftstätigkeit grundsätzlich aus zwei Perspektiven (=doppelt) zu betrachten: der Inside-Out Perspektive (= Impact Materiality), und der Outside-In Perspektive, (= Financial Materiality).

Die Inside-Out Betrachtung beziffert die tatsächlichen und potenziellen Auswirkungen („impacts“) des unternehmerisches Handeln auf unterschiedliche Nachhaltigkeitsthemen. Die Outside-In-Perspektive („finanzielle Wesentlichkeit“) betrachtet Chancen und Risiken von Nachhaltigkeitsthemen auf die finanzielle Lage und die Zukunftsfähigkeit eines Unternehmens.

Wesentlichkeit und Berichtspflicht

Ein Thema gilt als wesentlich, sobald es Risiken und Chancen für den Geschäftserfolg birgt (Outside-In Perspektive) oder die Geschäftstätigkeit signifikante Auswirkungen auf Umwelt und Umfeld hat (Inside-Out-Perspektive). Ein Thema ist also bereits zwingend berichterstattungspflichtig, wenn nur aus Sicht einer der beiden Perspektiven als wesentlich gilt.

Unternehmen sind verpflichtet, alle als „wesentlich“ identifizierte Themen gemäß der maßgeblichen European Sustainable Reporting Standards (ESRS) offenzulegen und durch Wirtschaftsprüfer testieren zu lassen. Der Bericht beinhaltet neben der Ist-Analyse Angaben zu Strategie und Governance, Informationen zu umgesetzten Maßnahmen sowie Ziele und Kennzahlen.

Nachvollziehbarkeit und jährliche Überprüfung

Die Wesentlichkeitsanalyse ist ein kontinuierlicher Prozess, dessen Inhalte regelmäßig aktualisiert und überprüft werden. Im Rahmen der CSRD ist auch Transparenz in Bezug auf die Methodik gefordert, wie die Wesentlichkeitsanalyse nach der Doppelten Materialität durchgeführt wurde.

Exemplarische Anwendung der Doppelten Wesentlichkeit

Um die praktische Anwendung der doppelten Wesentlichkeit darzustellen, soll das Beispiel eines Herstellers und Fullservice-Providers von Seilbahnen dienen.

Outside-In Perspektive: Aus Sicht der finanziellen Wesentlichkeit kann sich in unserem Beispiel beispielsweise das Thema Klimawandel auf die kurz-, mittel- und langfristige Einnahmen- und Ertragssituation auswirken. Die globale Erwärmung stellt eine Bedrohung für den Skitourismus dar, die zu einem sinkenden Absatzmarkt für den Seilbahnhersteller führen kann. Als sozialer Aspekt sei der Fachkräftemangel angeführt, der zu Engpässen in Produktion oder Servicegeschäft führen kann. Aus Governance-Gesichtspunkten können unternehmerische Risiken entstehen, wenn Genehmigungsverfahren verschärft und bspw. Neubauprojekte verhindert werden.

Inside-Out Perspektive: Aus Sicht der Impact Materiality kann die Geschäftstätigkeit des Unternehmens negative Auswirkungen auf Umwelt und Gesellschaft haben. Hauptreiber sind Treibhausgasemissionen bei Produktion und Betrieb der Anlagen, Umweltschäden durch deren Bau, aber auch Arbeits- und Sozialstandards entlang der Lieferkette oder Compliance Themen (z.B. bei der Auftragsvergabe).

ESRS- und Branchenstandards als Kriterien-Kompass

Risiken und Chancen liegen also nicht nur in der direkten Geschäftstätigkeit, sondern auch vorgelagert in der Lieferkette und nachgelagert in der Nutzungsphase eines Produktes. Um zu ermitteln, welche Themen aus Sicht eines Unternehmens im Sinne der Doppelten Materialität wesentlich sind, hat das Unternehmen eine Wesentlichkeitsanalyse nach den Vorgaben der CSRD durchzuführen.

Im Rahmen der Berichtspflicht sind die thematischen ESRS-Standards Grundlage der Überprüfung und bieten eine Liste potenziell wesentlicher Themen. Darüber hinaus helfen branchenspezifische Standards und Nachhaltigkeitsratings bei der Einschätzung, welche Themen typischerweise für ein Unternehmen einer bestimmten Industrie wesentlich sind.

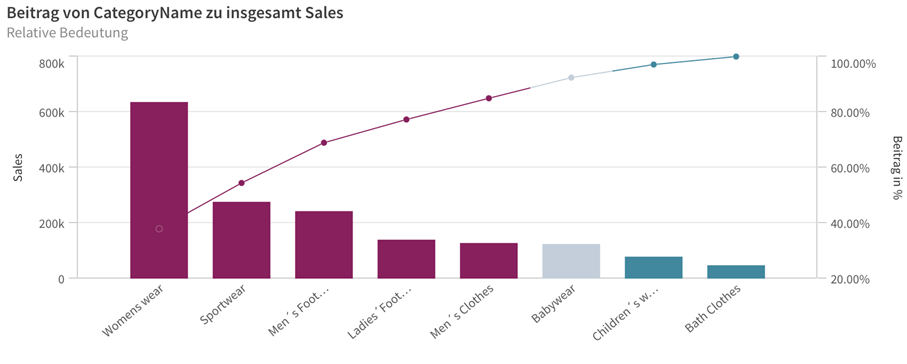

Mittels einer weitergehenden Umfeldanalyse können die ermittelten Themen in eine Rangfolge gebracht werden. Guter Ausgangspunkt einer Priorisierung sind erfahrungsgemäß die wesentlichen Umsatzquellen, Kostentreiber und Investitionsfelder der Unternehmen. Nach der Priorisierung muss eine Wesentlichkeitsschwelle festgelegt werden. Alle Themen, die diese Schwelle überschreiten, sind Berichterstattungs-pflichtig und müssen aufgeführt werden.

ESG beinhaltet zahlreiche Synergien

Die Wesentlichkeitsanalyse ermöglicht es Unternehmen, neben relevanten Nachhaltigkeitsthemen auch Unternehmens-strategische und operatives Optimierungspotenziale zu identifizieren. Dadurch können Unternehmen ihre Ressourcen effektiver einsetzen und neben ihrer Nachhaltigkeit auch ihre Wettbewerbsfähigkeit zu verbessern.

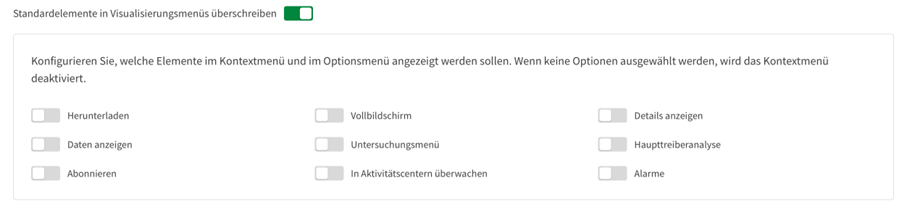

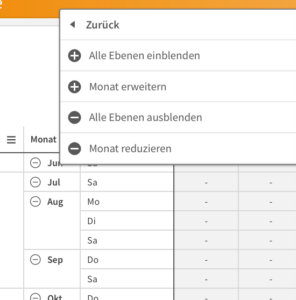

Weil die Ergebnisse von Wesentlichkeitsanalysen sehr individuell sind, gibt es im Gegensatz zu Finanzkennzahlen kaum Standards und Automatismen. Heterogene Datenquellen, -typen, -formate sind die Regel, und die erste Meile der Datenintegration entsprechend komplex. Neben internen Quellen gilt es externe zu berücksichtigen. Einige Daten können direkt ermittelt, andere nur indirekt erhoben oder kalkulatorisch bestimmt werden. Datenformate reichen von Papierform bis zu strukturierten Reporting-Standards und Datenzyklen sind beliebig von permanent bis mehrjährig, wodurch Abgrenzungen erforderlich werden.

Aus Daten Wissen machen

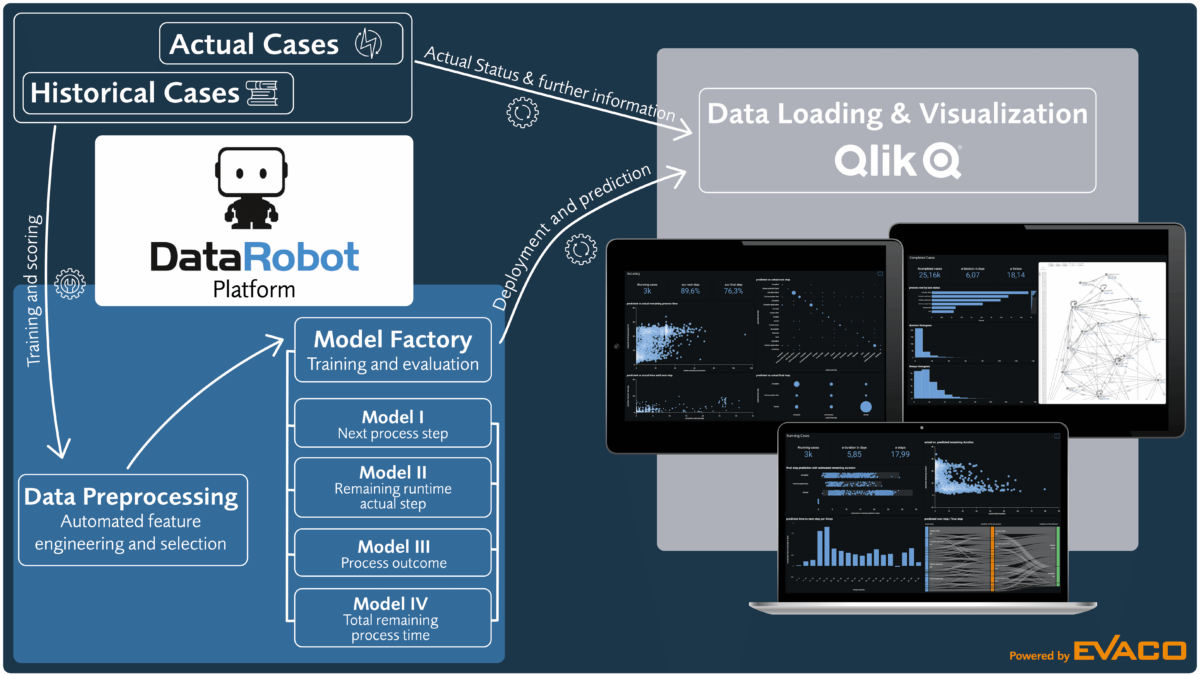

Digitalisierung und unternehmerische Nachhaltigkeit sind nicht nur untrennbar miteinander verbunden, sondern bilden eine Symbiose. Digitale Technologien ermöglichen Effizienzsteigerungen und Energieeinsparungen. Künstliche Intelligenz kann Umweltentwicklungen und Geschäftsereignisse prognostizieren und in Echtzeit Prozesse beeinflussen.

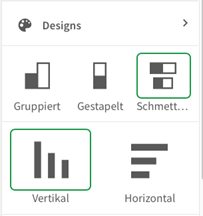

Durch Business Analytics und den Einsatz von AI lassen sich Synergien materialisieren, die bei allen Stakeholdern punkten und Nachhaltigkeit im Wortsinn verkörpern: wirtschaftliche Nachhaltigkeit ebenso wie verantwortungsbewusster und Ressourcen-schonender Umgang mit der Umwelt sowie Verantwortungsbewusstsein gegenüber nachfolgenden Generationen.

Rechtzeitig anfangen

Die Komplexität einer Wesentlichkeitsanalyse wird oft unterschätzt, weil die gesamte Wertschöpfungskette betrachtet werden muss und die Outside-in Betrachtung Neuland darstellt. Um fundierte Ergebnisse durch die Wesentlichkeitsanalyse zu erhalten, müssen verschiedenste Informations- und Datenquellen angezapft und abgebildet werden. Neben geeigneten Reporting- und Planungstools braucht man Zeit für Vorbereitung, Datenerhebung und -konsolidierung.

Die Wesentlichkeitsanalysemehr ist dabei mehr als nur gesetzliche Auflage: sie liefert wichtige Einsichten zu Risiken und Chancen, die zur Weiterentwicklung der Unternehmensstrategie beitragen und Ausgangspunkt eines Stakeholderdialogs sein können. An dieser Stelle schlagen Business Analytics und der Einsatz von KI neue Kapitel der digitalen Transformation auf.